Synthèse de données de matting humain multi-instances avec MaskRCNN et BG20K

Table des liens

Abstrait et 1. Introduction

-

Travaux connexes

-

MaGGIe

3.1. Matting d'instance guidé par masque efficace

3.2. Cohérence temporelle Feature-Matte

-

Ensembles de données de matting d'instance

4.1. Matting d'instance d'image et 4.2. Matting d'instance vidéo

-

Expériences

5.1. Pré-entraînement sur les données d'image

5.2. Entraînement sur les données vidéo

-

Discussion et Références

\ Matériel supplémentaire

-

Détails de l'architecture

-

Matting d'image

8.1. Génération et préparation de l'ensemble de données

8.2. Détails de l'entraînement

8.3. Détails quantitatifs

8.4. Plus de résultats qualitatifs sur les images naturelles

-

Matting vidéo

9.1. Génération de l'ensemble de données

9.2. Détails de l'entraînement

9.3. Détails quantitatifs

9.4. Plus de résultats qualitatifs

8. Matting d'image

Cette section développe le processus de matting d'image, fournissant des informations supplémentaires sur la génération de l'ensemble de données et des comparaisons complètes avec les méthodes existantes. Nous examinons en détail la création des ensembles de données I-HIM50K et M-HIM2K, offrons des analyses quantitatives détaillées et présentons d'autres résultats qualitatifs pour souligner l'efficacité de notre approche.

8.1. Génération et préparation de l'ensemble de données

L'ensemble de données I-HIM50K a été synthétisé à partir de l'ensemble de données HHM50K [50], qui est connu pour sa vaste collection de mattes d'images humaines. Nous avons utilisé un modèle MaskRCNN [14] Resnet-50 FPN 3x, entraîné sur l'ensemble de données COCO, pour filtrer les images à une seule personne, résultant en un sous-ensemble de 35 053 images. Suivant la méthodologie InstMatt [49], ces images ont été composées sur des arrière-plans divers provenant de l'ensemble de données BG20K [29], créant des scénarios multi-instances avec 2 à 5 sujets par image. Les sujets ont été redimensionnés et positionnés pour maintenir une échelle réaliste et éviter un chevauchement excessif, comme indiqué par des IoU d'instance ne dépassant pas 30 %. Ce processus a généré 49 737 images, avec une moyenne de 2,28 instances par image. Pendant l'entraînement, les masques de guidage ont été générés en binarisant les mattes alpha et en appliquant des opérations aléatoires de dropout, dilatation et érosion. Des exemples d'images de I-HIM50K sont affichés dans la Fig. 10.

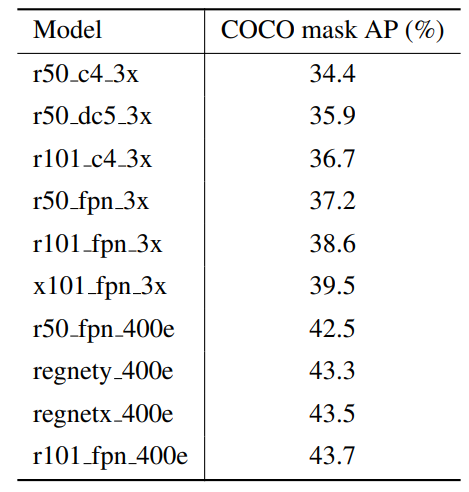

\ L'ensemble de données M-HIM2K a été conçu pour tester la robustesse du modèle face à des qualités de masque variables. Il comprend dix masques par instance, générés à l'aide de différents modèles MaskRCNN. Plus d'informations sur les modèles utilisés pour ce processus de génération sont présentées dans le Tableau 8. Les masques ont été associés aux instances en fonction de l'IoU le plus élevé avec les mattes alpha de référence, garantissant un seuil IoU minimum de 70 %. Les masques qui ne respectaient pas ce seuil ont été générés artificiellement à partir de la référence. Ce processus a abouti à un ensemble complet de 134 240 masques, avec 117 660 pour les images composites et 16 600 pour les images naturelles, fournissant un benchmark robuste pour l'évaluation du matting d'instance guidé par masque. L'ensemble de données complet I-HIM50K et M-HIM2K sera publié après l'acceptation de ce travail.

\

\

\

:::info Auteurs :

(1) Chuong Huynh, University of Maryland, College Park (chuonghm@cs.umd.edu) ;

(2) Seoung Wug Oh, Adobe Research (seoh,jolee@adobe.com) ;

(3) Abhinav Shrivastava, University of Maryland, College Park (abhinav@cs.umd.edu) ;

(4) Joon-Young Lee, Adobe Research (jolee@adobe.com).

:::

:::info Cet article est disponible sur arxiv sous licence CC by 4.0 Deed (Attribution 4.0 International).

:::

\

Vous aimerez peut-être aussi

Retrait Important de LINK Noté depuis un Portefeuille Binance

ZCash – Analyse de la possibilité pour ZEC d'atteindre 750 $ alors que le volume atteint 744 M$