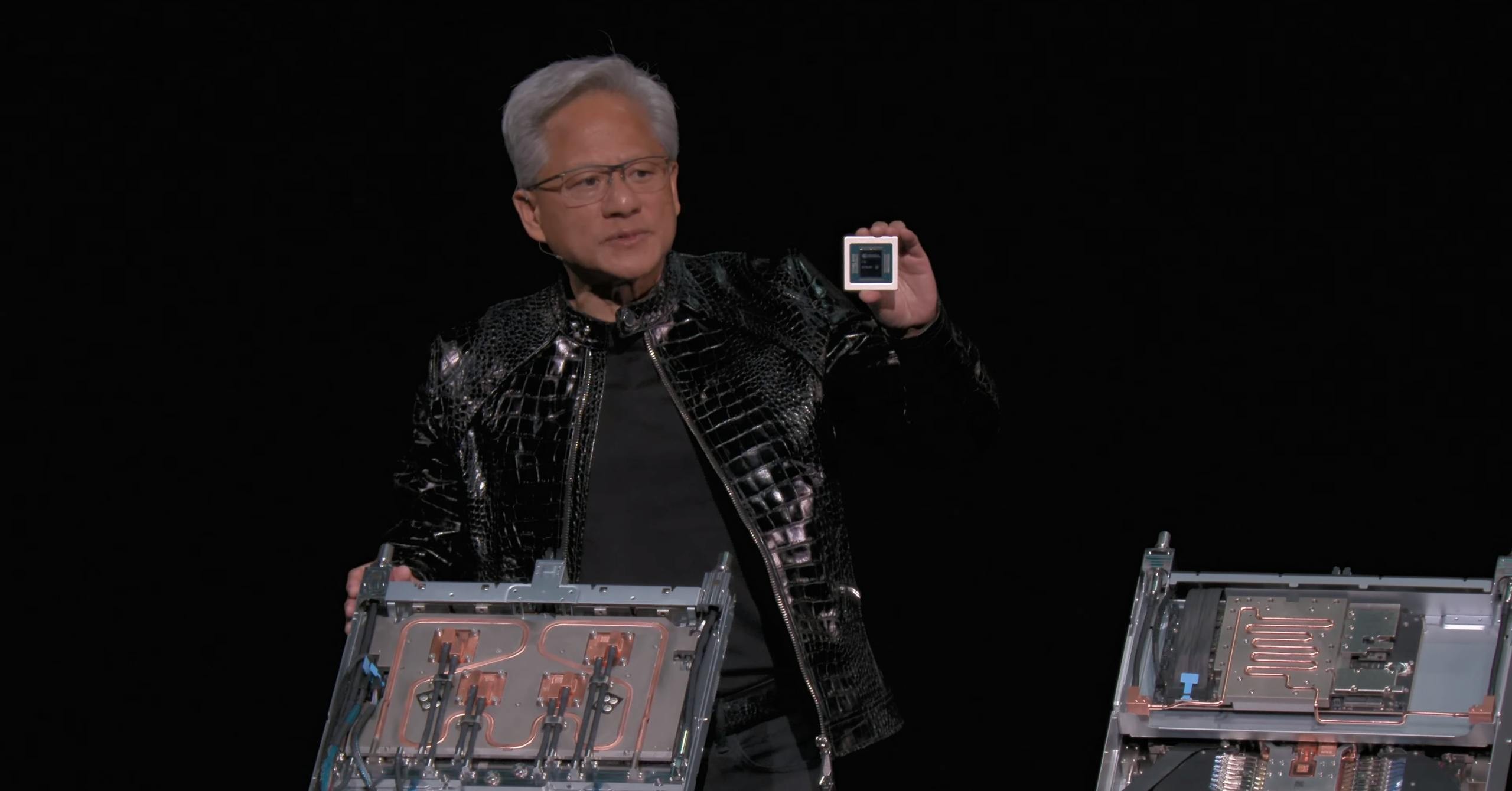

NVIDIA 執行長黃仁勳在 CES 2026 再度揭示下一代 AI 超級晶片「Vera Rubin」藍圖!Vera Rubin 平台延續 NVIDIA「超級晶片」的整合設計理念,將全新的 Vera CPU 與 Rubin GPU 緊密結合在單一載板上。

黃仁勳表示 Vera Rubin 的設計初衷是為了解決當前產業面臨的根本性挑戰:AI 運算所需的算力正以驚人速度攀升。他強調,這款以美國天文學家薇拉・魯賓(Vera Florence Cooper Rubin)命名的新架構,已經正式進入全面量產。

Rubin 架構最早於 2024 年的 COMPUTEX 展會上首度揭露,是 NVIDIA 維持高速硬體迭代策略的最新成果。Rubin 將正式取代現行的 Blackwell 架構,而 Blackwell 先前則是接替 Hopper 與 Lovelace 架構的定位。

Photo Credit:NVIDIA

NVIDIA 近期陸續宣布與 Anthropic、OpenAI 及 AWS 等重量級 AI 業者建立合作夥伴關係,這些企業都將成為 Rubin 架構的首批客戶。

從技術規格來看,Vera Rubin 由六顆設計為協同運作的獨立晶片所組成,分別有 NVIDIA Vera CPU、NVIDIA Rubin GPU、NVIDIA NVLink 6 交換器、NVIDIA ConnectX-9 SuperNIC、NVIDIA BlueField-4 DPU和NVIDIA Spectrum-6 以太網路交換器。

其中 Rubin GPU 位居整體架構的核心位置,負責主要的 AI 運算任務;此外,Vera Rubin 也透過全新改良的 Bluefield 網路晶片與 NVLink 互連技術,針對現代 AI 系統日益嚴峻的儲存頻寬與晶片間互連瓶頸提出解決方案。Vera CPU 則專門針對 AI Agent 代理式推理的應用場景進行最佳化。

根據 NVIDIA 官方數據,Vera Rubin 可提供 3.6 EFLOPS FP4 推論效能,以及 1.2 EFLOPS FP8 訓練能力。在記憶體配置上,NVL144 配備 75TB 的快速記憶體,HBM4 頻寬達 13 TB/s,較 GB300 提升約 60%。系統採用 100% 液冷設計,支援 45°C 液冷散熱,並配備新型液冷匯流排,為 GW 級 AI 資料中心做好準備。

在效能表現方面,Rubin 架構在模型訓練任務上的運算速度較前代 Blackwell 架構提升 3.5 倍,在推論任務上更達到 5 倍的效能增幅,此外可將推理的 token 成本降低 10 倍,並將訓練 MoE 模型所需的 GPU 數量降低 4 倍。在能源效率方面,新平台每瓦電力所能支援的推論運算量也提升至 8 倍。

加入 INSIDE 會員,獨享 INSIDE 科技趨勢電子報,點擊立刻成為會員!

延伸閱讀:

-

【CES 2026】挑戰 Tesla FSD!NVIDIA 攜手賓士亮自駕推理模型 「Alpamayo」

-

【CES 2026】開源之王 NVIDIA 模型連發!開源數量超越 Google

您可能也會喜歡

RAKBank獲原則性批准推出阿聯酋穩定幣

Barclays投資Ubyx以推進穩定幣和代幣化存款基礎設施